Vous êtes pressé ? 🏃⚡

Voici l’essentiel de l’article pour tout comprendre en 30 secondes chrono ! ⏱️

👉 TL;DR : OpenAI lance GPT-4.1, mini et nano, trois nouveaux modèles réservés aux développeurs via API. Ils sont plus performants sur de nombreux points comme la compréhension des consignes et le multimodal, jusqu’à 83 % moins chers que GPT-4o, et capables de traiter jusqu’à 1 million de tokens. Idéal pour coder, automatiser et manipuler de gros volumes de données !

Une nouvelle fois, OpenAI a créé la surprise ! Le 14 avril 2025 ont été dévoilés trois nouveaux modèles d’intelligence artificielle : GPT-4.1, GPT-4.1 mini et GPT-4.1 nano. Ces modèles, exclusivement accessibles via l’API d’OpenAI, ne visent pas à remplacer GPT-4o — le modèle par défaut de ChatGPT depuis mai 2024 — mais bien à s’imposer comme des alliés de choix pour les développeurs et les entreprises technophiles. Ils incarnent une avancée notable dans la course à la performance, à la vitesse et au coût de l’IA générative.

Moins coûteux, plus rapides et conçus pour des usages concrets comme le codage, l’automatisation de tâches ou la compréhension de contextes complexes, ils marquent une étape stratégique pour OpenAI. LabSense vous livre un décryptage complet de cette nouvelle gamme qui pourrait bien redessiner la carte des usages professionnels de l’IA !

Announcing GPT-4.1, GPT-4.1 mini, and GPT-4.1 nano in the API.

— OpenAI Developers (@OpenAIDevs) April 14, 2025

TL;DR: Major improvements on coding, instruction following, and long context. 💥

00:00 Intro

02:18 Coding

04:53 Instruction following

06:58 Long context

10:22 Demos, pricing, and availability

20:00 @windsurf_ai pic.twitter.com/vviVb1pRqV

GPT-4.1 : une famille de modèles taillée pour les développeurs

OpenAI s’adresse ici directement aux professionnels du développement logiciel. Loin d’être une version allégée de GPT-4o, la version 4.1 est un modèle repensé pour répondre à des besoins spécifiques. Avec des fenêtres contextuelles étendues et une rigueur accrue dans l’exécution des instructions, celle-ci répond mieux aux attentes des entreprises et des créateurs d’outils IA.

Les trois variantes du modèle GPT-4.1

🦾 Version 4.1 : le modèle le plus complet et performant

- Fenêtre contextuelle : 1 million de tokens

- Prix API : 2 $ par million de tokens en entrée, 8 $ en sortie

- Usage idéal : traitements complexes, analyse de bases de code complètes, création d’agents intelligents

Le modèle principal GPT-4.1 brille sur les benchmarks. Il atteint jusqu’à 54,6 % sur SWE-bench Verified, contre 33,2 % pour GPT-4o, illustrant sa supériorité pour les tâches de programmation avancées. Il se distingue également par une meilleure compréhension des consignes et une grande fiabilité dans le respect des structures de réponse.

👛 GPT-4.1 mini : l’efficacité à prix réduit

- Prix API pour 1 million de tokens : 0,40 $ (entrée), 1,60 $ (sortie)

- Avantage : 83 % moins cher que GPT-4o

- Usage idéal : applications IA à moindre coût, assistants IA légers, prototypage rapide

La version mini conserve une très bonne efficacité pour un coût très compétitif. Il permet aux startups et équipes techniques à budget limité de déployer des solutions IA robustes à grande échelle.

🪶 GPT-4.1 nano : l’IA ultralégère pour les tâches simples

- Prix API (pour 1M de tokens) : 0,10 $ (entrée), 0,40 $ (sortie)

- Usage idéal : autocomplétion, classification, automatisation à faible latence

Conçu pour des cas d’usage fréquents et peu complexes, la verison nano est parfait pour les systèmes d’analyse temps réel ou les flux de travail automatisés de masse.

« Ces modèles permettent aux développeurs de créer des agents nettement plus performants pour les tâches d’ingénierie logicielle concrètes. » — OpenAI

Cas d’usages concrets : ce que GPT-4.1 change pour les pros

Voici quelques scénarios où le modèle 4.1 de ChatGPT et ses déclinaisons peuvent faire la différence.

🧑💻 Analyse de code en profondeur

- Intégration d’un corpus de code entier dans une seule requête

- Détection d’erreurs, suggestions de refactoring, génération de tests unitaires.

📄 Documentation automatique

Transformation de notes techniques ou fichiers README en documentation complète et cohérente.

⚙️ Génération de contenu personnalisé en masse

Génération d’articles, descriptifs produits, contenus SEO basés sur des données métier ou open data.

🤖 Automatisation de chatbots spécialisés

Modélisation de réponses selon le ton, les formats et les besoins du service client ou d’un support technique.

Et pour les entreprises ?

Avec son API, OpenAI ouvre un large champ des possibles. Voici quelques cas d’usage concrets.

📦 Pour le e-commerce

- Génération de fiches produit à grande échelle avec la version mini

- Assistance client automatisée via chatbot alimenté par GPT-4.1

- Analyse de sentiments ou avis clients avec le modèle nano

📰 Pour les médias & contenus

- Résumé de documents longs (jusqu’à 750 000 mots !) avec GPT-4.1

- Réécriture SEO et planification éditoriale automatique

🧠 Pour l’engineering

- Refactoring de code, génération de tests unitaires

- Documentation technique automatisée

- Détection d’erreurs dans des bases de code volumineuses

💡 Le saviez-vous ?

Les modèles Allready, la plateforme IA de LabSense, utilisent les derniers LLM de pointe. Ils peuvent vous aider à booster les performances de votre contenu, qu’il s’agisse d’annonces immobilières, d’articles ou de fiches produits. Les tester, c’est les adopter !

Performances : un net progrès sur tous les fronts

GPT-4.1 établit une nouvelle référence dans quatre domaines clés : le codage, le suivi des instructions, le raisonnement à long terme et les capacités multimodales.

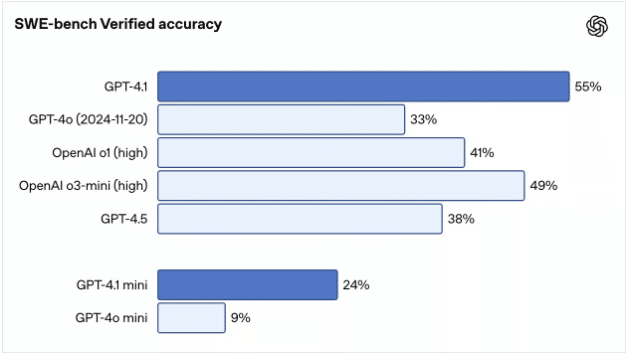

Codage : du prototype au code de production

Sur le benchmark SWE-bench Verified, GPT-4.1 atteint 54,6 %, contre 33,2 % pour GPT-4o et 38 % pour GPT-4.5. Il dépasse même les modèles plus récents comme o1 et o3-mini. Sur le diff polyglotte d’Aider, il affiche une précision de 52,9 %, là encore devant GPT-4o (22,7 %) et GPT-4.5 (44,9 %). Il génère moins d’erreurs inutiles : seulement 2 % de modifications superflues contre 9 % pour GPT-4o.

OpenAI a également montré dans une démo comparative qu’il surpasse GPT-4o dans 80 % des cas lors de la création d’une application web. Des retours concrets d’acteurs comme Windsurf (+60 % sur leur benchmark interne) et Qodo (+55 % de suggestions utiles sur GitHub) confirment ces résultats.

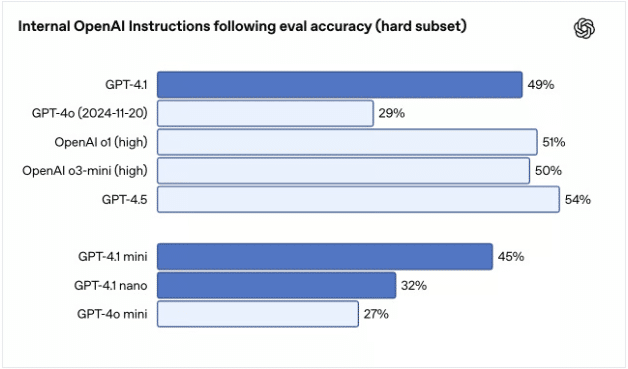

Suivi des instructions : plus rigoureux, plus fiable

GPT-4.1 brille sur les tâches complexes impliquant plusieurs étapes ou formats stricts :

- Hard Subset (OpenAI) : 49,1 % (vs. 29,2 % pour GPT-4o)

- IFEval : 87,4 % de conformité aux consignes (vs. 81 % pour GPT-4o)

- MultiChallenge : 38,3 % (vs. 27,8 % pour GPT-4o)

Cela se traduit par une meilleure exécution des workflows automatisés, notamment avec des sorties structurées (XML, YAML, markdown) sans reformulation inutile.

Contexte étendu : raisonnement à l’échelle d’un million de tokens

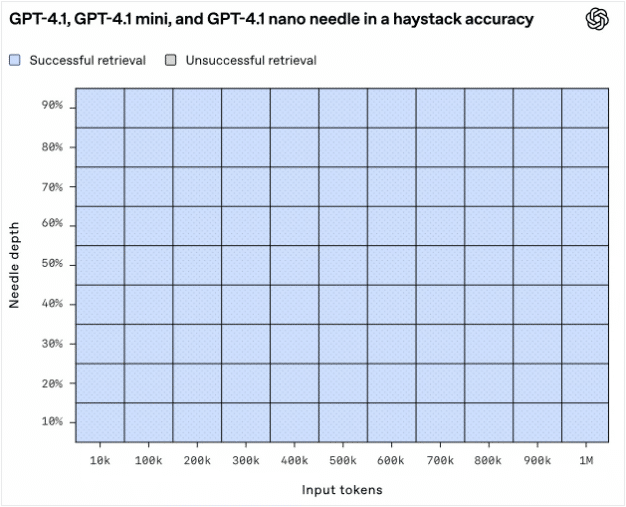

Tous les modèles GPT-4.1 prennent en charge jusqu’à 1 million de tokens sans coût supplémentaire. Dans le test « aiguille dans la botte de foin » d’OpenAI, ils ont su retrouver une information cachée n’importe où dans l’entrée.

Sur Graphwalks, qui mesure le raisonnement multi-sauts sur de longs contextes, GPT-4.1 atteint 61,7 %, contre 41,7 % pour GPT-4o. Des entreprises comme Thomson Reuters (+17 % en analyse juridique) ou Carlyle (+50 % en extraction de données financières) ont confirmé son efficacité sur des cas réels.

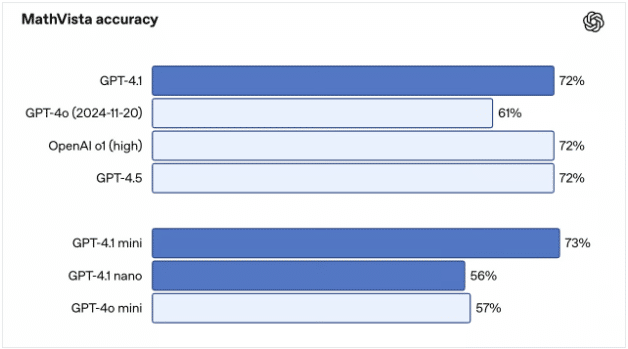

Multimodalité : vers une meilleure compréhension visuelle

GPT-4.1 progresse aussi dans l’analyse d’images et de vidéos :

- Video-MME : 72 % (vs. 65,3 % pour GPT-4o)

- MMMU : 74,8 % (vs. 68,7 %)

- MathVista : 72,2 %

Surprise : la version 4.1 mini atteint 73,1 % sur MathVista, devançant même la version complète. Un excellent compromis pour les cas d’usage visuels rapides et légers.

En résumé

GPT-4.1 surpasse ses prédécesseurs dans presque tous les domaines techniques — que ce soit en code, en logique, en traitement du langage ou en analyse multimodale — tout en étant plus accessible via une API dédiée aux développeurs. GPT-4.1 est donc idéalisé pour les tâches complexes avec des contextes moyens, mais nécessite des prompts bien construits pour garantir la qualité de sortie.

Comment y accéder ?

OpenAI frappe fort avec une stratégie de prix pensée pour séduire :

- GPT-4.1 mini est 83 % moins cher que GPT-4o

- Le modèle 4.1 standard est 26 % moins cher sur les requêtes médianes

Ces prix visent à concurrencer directement les offres de Google (Gemini 2.5) et Anthropic (Claude 3.7 Sonnet).

À lire aussi

Llama 4 Scout, Maverick et Behemoth : quoi de neuf du côté de l’IA multimodale by Meta ?

« Le 5 avril 2025, Meta a frappé fort en dévoilant les premiers modèles de sa série Llama 4, conçus pour être nativement multimodaux. Leurs noms ? Scout et Maverick. Ils seront bientôt rejoints par le géant Behemoth… » >> Lire la suite.

Gemini passe à la vitesse supérieure : les nouveautés de l’IA multimodale signée Google

« Le 18 mars 2025, Google a frappé fort avec les dernières évolutions de son intelligence artificielle Gemini. Des fonctionnalités inédites viendraient enrichir l’expérience utilisateur, rendant l’IA toujours plus intuitive, … » >> Lire la suite

Claude 3.7 Sonnet : comment Anthropic innove pour rivaliser avec OpenAI, xAI et DeepSeek

« La course à l’intelligence artificielle générative prend un nouveau tournant avec le lancement de Claude 3.7 Sonnet par Anthropic. Ce modèle de langage avancé repousse les limites en matière de codage… » >> Lire la suite.

➡️ À noter : GPT-4.1, mini et nano ne sont pas accessibles via ChatGPT. Pour les utiliser, il faut passer par l’API d’OpenAI ou le Playground, où il est possible de tester les trois variantes, d’ajuster les invites système, ou de simuler des workflows complexes.

Et surtout, vous pouvez envoyer jusqu’à 1 million de tokens en un seul appel, sans coût supplémentaire lié à la taille du contexte. Idéal pour traiter des documents longs (PDF, logs, dossiers juridiques) à moindre coût.

Quelle est la suite du programme pour Open AI ?

GPT-4.1, bien qu’indisponible sur l’interface ChatGPT, préfigure une nouvelle ère d’outils IA intégrables via API dans les systèmes des entreprises. Ce lancement signe aussi la fin du support de GPT-4.5, un modèle intermédiaire qui avait été discrètement introduit entre GPT-4 et GPT-4o. OpenAI semble désormais concentrer ses efforts sur une offre plus structurée autour de GPT-4.1 et du futur GPT-5.

En ce qui concerne GPT-5, les utilisateurs devront encore un peu patienter : ce modèle est attendu pour remplacer GPT-4o dans les mois à venir. Ce dernier, bien qu’amélioré récemment avec la génération d’images, reste limité à 128 000 tokens et coûteux à l’usage.

GPT-4.1 : un complément plutôt qu’un remplaçant

Si GPT-4o reste plus complet (traitement multimodal, génération d’image et de voix), GPT-4.1 fait moins… mais mieux. Alors en attendant le modèle GPT-5, OpenAI assume : le nouveau modèle demande des prompts plus explicites, mais offre un meilleur respect des consignes, une cohérence accrue et une capacité à s’adapter aux formats rigoureux. Le lancement de GPT-4.1, mini et nano marque une étape stratégique pour OpenAI : proposer aux développeurs et aux entreprises des modèles plus spécialisés, plus abordables et mieux adaptés à leurs besoins réels. Avec une fenêtre contextuelle record, une précision en hausse sur les tâches techniques et des coûts d’utilisation réduits, GPT-4.1 semble taillé pour révolutionner les cas d’usage IA professionnels.

✉️ Et maintenant ?

Vous souhaitez profiter du potentiel de GPT-4.1 pour vos contenus ? LabSense vous accompagne pour intégrer ces modèles à vos process de production, avec une expertise unique de l’IA appliquée aux données, aux contenus marketing et SEO.

🔗 Contactez nos experts pour une démo personnalisée ou un audit de vos contenus actuels.

Et vous ?

*Sondage réalisé avec Allready, la plateforme IA de LabSense